of Technology and Educational Innovation Vol. 8. No. 1.

Junio 2022 - pp. 5-16 - ISSN: 2444-2925

DOI: https://doi.org/10.24310/innoeduca.2022.v8i1.8465

JUSECA: Un juego serio para la comprensión de algoritmos

Automatización e Integración (LaSDAI), Universidad de Los Andes, Venezuela

Automatización e Integración (LaSDAI), Universidad de Los Andes, Venezuela

1. INTRODUCCIÓN

En los cursos introductorios de programación, los estudiantes presentan varias dificultades, tales como: carencias en el razonamiento lógico (Pérez, & Castro, 2018a); bajo rendimiento académico (Pérez, & Pedroza, 2018); desmotivación (Pérez, & Castro, 2018b); o problemas en la comprensión de algoritmos (Miljanovic, & Bradbury, 2016), entre otras. Particularmente, la comprensión de algoritmos es muy importante para distinguir lo que está haciendo un algoritmo de lo que se supone que debe hacer (Gugerty, & Olson, 1986) o entender un algoritmo escrito por otra persona para trabajar sobre él (Ramalingam, & Wiedenbeck, 1997).

Dada la importancia de la comprensión de algoritmos, se han propuesto varias estrategias dirigidas a estudiantes universitarios. Estas estrategias se enmarcan, según Rosanigo y Paur (2006), en el aprendizaje basado en problemas, y pueden ubicarse en dos categorías: primero, en el contexto del constructivismo, que consiste en el planteamiento y resolución de problemas, permitiendo al estudiante buscar, razonar e integrar los conocimientos previos; y segundo, desde el punto de vista del aprendizaje didáctico, que consiste en seleccionar problemas que consideren los conocimientos que el estudiante requiere para alcanzar las soluciones y las motivaciones para resolverlos.

Recientemente, se han popularizado estrategias que pueden ubicarse en la categoría orientada al aprendizaje didáctico. Según Carrillo et al. (2017), en esta categoría se prioriza la adquisición de las competencias y conocimientos de algoritmos mediante el uso de recursos como computadoras, Internet y dispositivos móviles. Algunos ejemplos son Fava et al. (2016), quienes presentan una herramienta educativa denominada “Algolipse” que está destinada a facilitar y mejorar el aprendizaje de estructuras de datos y algoritmos escritos en JAVA, mediante la visualización del estado de ejecución de los algoritmos y las estructuras de datos con la representación gráfica de árboles y nodos; y Velázquez-Iturbide y Pérez-Carrasco (2016), muestran una extensión del sistema “SRec” destinado para apoyar el diseño de algoritmos de programación dinámica en JAVA, que consiste en visualizar de forma gráfica y progresiva la ejecución de algoritmos recursivos con grafos de dependencia, para construir el algoritmo correcto en cada problema.

Otros ejemplos son Rodero et al. (2017), quienes describen una experiencia con la herramienta “VisBack”, la cual permite visualizar por medio de grafos la ejecución de los algoritmos de combinatoria escritos en JAVA, basados en la técnica de vuelta atrás. Por su parte, Miljanovic y Bradbury (2016), aplican un juego denominado “Robot ON!” como alternativa para el aprendizaje de programación mediante la comprensión de programas escritos en C++, involucrando una interfaz que se basa en depurar, modificar y probar el código, para resolver las tareas del juego correctamente.

De las estrategias mencionadas anteriormente, se puede notar que coinciden en mostrar de alguna manera la ejecución de los algoritmos que el estudiante debe comprender. No obstante, la tendencia es trabajar con un lenguaje de programación específico, y en algunos casos, se concentran en la comprensión de algoritmos avanzados, imposibilitando su uso en un curso introductorio de programación que utilice un lenguaje de programación distinto y que se enfoque en algoritmos particulares, como es el caso de la asignatura “Programación 1” de la Universidad de Los Andes.

En la asignatura “Programación 1”, el objetivo principal es que los estudiantes desarrollen habilidades en el análisis, diseño y construcción de programas codificados en un lenguaje de programación, para resolver problemas presentados en orden de complejidad creciente. Para alcanzar ese objetivo, la metodología de enseñanza incluye: clases magistrales, prácticas en el laboratorio, videos complementarios y guías de ejercicios. Particularmente, en esta asignatura se trabaja con algoritmos en lenguaje C, utilizando inicialmente la biblioteca PR1-ULA (Pérez, & Azuaje, 2019), en aras de facilitar el primer acercamiento de los estudiantes a la programación.

La necesidad de elaborar una estrategia propia que permita trabajar con la biblioteca PR1-ULA ha despertado el interés por los juegos serios, porque éstos han sido aplicados a nivel universitario en diferentes disciplinas, incluyendo áreas afines a la informática y computación. De acuerdo con Calderón et al. (2019), los juegos serios tienen como objetivo principal la enseñanza, entretenimiento e información, ubicándose su propósito más allá de la diversión. Por ejemplo, en la educación universitaria, han sido utilizados los juegos serios para desarrollar habilidades de trabajo en equipo (Poy-Castro et al., 2015); concientizar a los estudiantes universitarios acerca del cuidado del medio ambiente y el uso responsable de la energía (Maldonado et al., 2017); o enseñar el idioma francés (Castro et al., 2018), entre otros.

En las áreas de la informática y computación a nivel universitario, los juegos serios se han desarrollado para cumplir ciertos objetivos en la formación, como por ejemplo, desarrollar el pensamiento computacional a través de un juego que se enfoca en la resolución de un rompecabezas, donde el jugador controla un mini robot asignándole diversos comandos (Kazimoglu et al., 2012); aprender programación mediante juegos que contienen preguntas de desarrollo o verdadero/falso (Garcia-Iruela, & Hijón-Neira, 2017); o estimular el razonamiento lógico mediante preguntas de selección, con una dinámica similar al popular juego conocido como ¿Quién quiere ser millonario? (Pérez, & Castro, 2018a), entre otros.

Para la elaboración de los juegos serios se han sugerido varios lineamientos metodológicos. Por ejemplo, Cano et al. (2016), proponen una metodología para el diseño de juegos serios llamada MECONESIS, la cual considera a los actores, contexto de uso, perfiles de usuario y mecánicas del juego. Esta metodología se divide en cuatro etapas: análisis sobre el diseño del juego; preproducción enfocada en la interfaz del juego; producción relacionada con la implementación y funcionamiento; y postproducción correspondiente a la evaluación del resultado final. Recientemente, Taipe et al. (2017) analizaron algunos trabajos sobre la elaboración de juegos serios, y concluyeron que es necesario contemplar cuatro fases: análisis, para identificar los requerimientos, tomando en cuenta los escenarios, aspectos pedagógicos, contenidos lúdicos y contenidos de aprendizaje; diseño, que permite describir la estructura de la organización de los componentes del juego, y definir los puntos principales sobre el esquema de la jugabilidad; desarrollo, donde se establecen los recursos de software para la construcción del juego; y validación, que se relaciona con los objetivos educativos, la funcionalidad y la calidad del juego.

Existe un modelo de diseño instruccional que integra las fases anteriormente descritas, el cual se denomina ADDIE (Análisis, Diseño, Desarrollo, Implementación y Evaluación). Según Molenda (2003) y Cuesta (2010), se desconoce el autor de este modelo, sin embargo, ha sido implementado recientemente en los juegos serios, como por ejemplo: para informar a usuarios acerca de temas ambientales relacionados con la clasificación de los residuos (Alcid et al., 2017); entrenar la habilidad espacial y razonamiento geométrico mediante un Tangram para dispositivos móviles (Renavitasari, & Supianto, 2018); y reforzar la comprensión de algoritmos y conceptos de programación a nivel de secundaria mediante un juego de mesa (Von Wangenheim et al., 2019).

En general, un juego serio, diseñado con cualquiera de las metodologías mencionadas anteriormente, es una alternativa de aprendizaje que ha generado resultados positivos en los estudiantes universitarios. Por lo tanto, en esta investigación se considera que un juego serio es una alternativa prometedora para facilitar la comprensión de algoritmos en estudiantes universitarios. En consecuencia, el objetivo de esta investigación consiste en proponer un juego serio para la comprensión de algoritmos (cubriendo los requerimientos de la asignatura “Programación 1”), y evaluar su impacto (rendimiento, experiencia de usuario y usabilidad). Dado que la metodología ADDIE integra todas las fases de otras metodologías, ésta ha sido seleccionada para elaborar el juego serio de esta investigación.

2. METODOLOGÍA

2.1. Participantes

Inicialmente, participaron 58 estudiantes de la asignatura “Programación 1” de la Universidad de Los Andes. No obstante, sólo se tomaron en cuenta a 32 estudiantes porque se descartaron a quienes no realizaron todo el procedimiento, no cumplieron puntualmente el procedimiento o abandonaron la asignatura. 84.37% de los participantes fueron hombres (27) y 15.63% fueron mujeres (5), con un promedio de edad de 17.3 años y una desviación estándar de 0.94.

2.2. Procedimiento

El procedimiento se basó en la metodología ADDIE (ver sección 2.3). Primero, se desarrolló el juego serio JUSECA, siguiendo las primeras tres fases (Análisis, Diseño y Desarrollo) de la metodología ADDIE. Segundo, se aplicó a los participantes un diagnóstico para formar dos grupos equivalentes (grupo experimental y grupo de control). El diagnóstico estuvo constituido por 10 preguntas de razonamiento deductivo que debían ser respondidas en 40 minutos, cuyos enunciados fueron los mismos utilizados en Pérez y Castro (2018a). Tercero, se aplicó el juego serio al grupo experimental (fase de Implementación de la metodología ADDIE), y al mismo tiempo, se asignó la clásica guía de ejercicios al grupo de control. La aplicación del juego consistió en una asignación para la casa, cuyas indicaciones se hicieron mediante un video explicativo que especifica cómo descargar el juego, cómo jugar y qué se debe hacer luego de completar todo el juego. La guía de ejercicios contenía los enunciados de los mismos algoritmos utilizados en el juego, pero en un documento PDF. Cuarto, para cumplir la fase de Evaluación de la metodología ADDIE, se midió el rendimiento de ambos grupos (experimental y de control) mediante una evaluación ad hoc de rendimiento y se aplicó MEEGA+ (ver sección 2.4) para evaluar el juego en términos de experiencia de usuario y usabilidad. La evaluación ad hoc de rendimiento estuvo constituida por tres preguntas sobre la escritura de algoritmos presentados en orden de complejidad creciente.

2.3. ADDIE

El modelo de diseño instruccional ADDIE está constituido por cinco etapas: Análisis, Diseño, Desarrollo, Implementación y Evaluación. De acuerdo con Williams et al. (2003), para la etapa de Análisis se definen cinco indicadores generales: el perfil del estudiante, el objetivo de aprendizaje, la solución de formación, el tiempo disponible, y la descripción del modo para medir el éxito. Butler (2014), indica que, en la etapa de Diseño, la estructura de un juego educativo debe poseer siete atributos: objetivo del juego, reglas e instrucciones, promoción de la interacción, estimulación de la competición, retroalimentación y resultados, recompensa, y factor diversión. La etapa de Desarrollo consiste en ensamblar el contenido especificado en la etapa de Diseño. La etapa de Implementación tiene el propósito de proveer el juego a los usuarios. Finalmente, la etapa de Evaluación consiste en medir el impacto del juego.

2.4. MEEGA+

La metodología MEEGA+ (por sus siglas del inglés, Model for the Evaluation of Educational Games) fue desarrollada por Petri et al. (2018), la cual, proporciona un mecanismo para evaluar juegos educacionales según la experiencia de usuario y la usabilidad. Por un lado, la experiencia de usuario se divide en ocho dimensiones: confianza, desafío, satisfacción, interacción social, diversión, atención centrada, pertinencia, y percepción del aprendizaje. Por otro lado, la usabilidad del juego está dividida en cuatro dimensiones: estética, facilidad de aprendizaje, operatividad, y accesibilidad.

MEEGA+ provee un cuestionario estandarizado que distribuye en las doce dimensiones un total de treinta y dos ítems, cuyas respuestas utilizan la escala de Likert. En ese sentido, la metodología ofrece instrucciones claras para su aplicación, una hoja de cálculo para la recolección de los datos, un script para la obtención de los resultados, y la información necesaria para la interpretación de los datos según la técnica de estadística IRT (por sus siglas del inglés, Item Response Theory). De esta manera, se obtiene el parámetro θ que permite calificar el juego según tres categorías: baja calidad (θ < 42.5), buena calidad (42.5 <= θ < 65), y excelente calidad (θ >= 65).

3. RESULTADOS

3.1. JUSECA (JUego SErio para la Comprensión de Algoritmos)

En la etapa de Análisis de la metodología ADDIE se especificaron cinco aspectos: primero, el perfil del estudiante, que en este caso son estudiantes universitarios con nociones básicas de programación (variables, operadores, condicionales y ciclos), y según un diagnóstico realizado en Pérez (2019a), tienen la necesidad de acceso diario a Internet, creencia de competencia tecnológica, prioridad por la información gráfica y, en algunos casos, capacidad multitarea; segundo, objetivo de aprendizaje, el cual es fortalecer la comprensión de algoritmos básicos; tercero, solución de formación, que consiste en visualizar la ejecución de algoritmos escritos en lenguaje C mediante la biblioteca PR1-ULA, con el propósito de seleccionar correctamente el algoritmo que se relaciona con cada ejecución; cuarto, tiempo disponible, que en este caso no hay límite de tiempo; y quinto, modo para medir el éxito, el cual consiste en monitorear el rendimiento de los estudiantes.

En la etapa de Diseño se especificaron siete aspectos: primero, objetivo del juego, que en este caso consiste en recorrer simbólicamente un pequeño mapa que contiene tres lugares imaginarios del mundo; segundo, reglas e instrucciones, que se cubren mediante la explicación del juego e información sobre los controles; tercero, promover la interacción, la cual se hace mediante animaciones con gráficos de colores y sonidos; cuarto, competición, que se estimula con puntos adicionales en la asignatura para los estudiantes que culminen todo el juego; quinto, retroalimentación y resultados, que en este caso se muestran mensajes para indicar si las respuestas son correctas o no; sexto, recompensa, otorgando puntos dentro del juego por cada respuesta correcta; y séptimo, factor diversión, que se cubre incorporando una pequeña historia para generar un entorno desafiante.

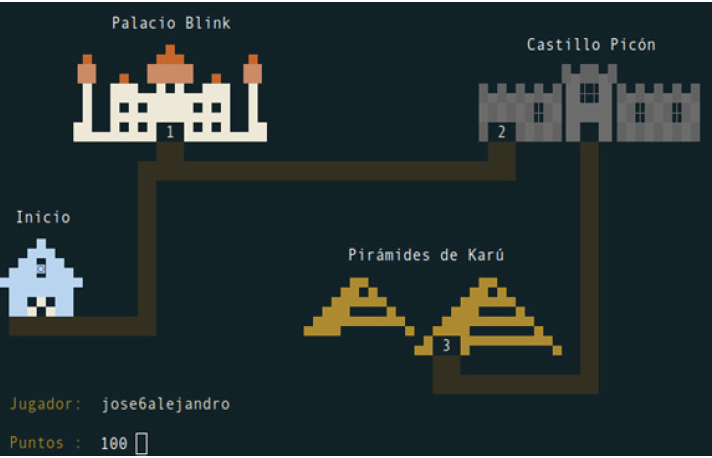

Específicamente, el juego comienza con una pequeña historia donde el jugador interpreta a un personaje intelectual que debe ayudar en diferentes lugares imaginarios del mundo, mediante la identificación de los algoritmos que se ejecutan. El mapa del juego muestra el recorrido que debe realizar el jugador, el cual corresponde a tres niveles de dificultad creciente asociados a los lugares imaginarios: en el primer nivel, el “Palacio Blink”, se ejecutan dos algoritmos con dificultad baja; en el segundo nivel, el “Castillo Picón”, se ejecutan cuatro algoritmos con dificultad media; y el en tercer nivel, las “Pirámides de Karú”, se ejecutan cuatro algoritmos con dificultad alta.

Durante el desarrollo del juego, cuando un jugador selecciona un algoritmo correcto, es recompensado con 50 puntos que son acumulados y permiten acceder a cada nivel del juego, necesitando acumular 500 puntos para completar el juego. No obstante, si el jugador comete un error, su travesía en el juego culmina. Cada algoritmo que se ejecuta en el juego se visualiza como una animación que se muestra por la terminal de Linux, seguido de la presentación de cuatro algoritmos, donde sólo uno corresponde con el algoritmo ejecutado, por lo tanto, el objetivo es analizar la ejecución y seleccionar el algoritmo correspondiente. Además, para cada algoritmo que se ejecuta, el jugador tiene las siguientes posibilidades: repetir la ejecución, seleccionar el algoritmo mostrado en la pantalla o ver los otros algoritmos.

La etapa de Desarrollo del juego se llevó a cabo en lenguaje C, haciendo uso de la biblioteca PR1-ULA, la cual permite programar fácilmente animaciones con colores y sonidos. En la Figura 1, se muestra el mapa del juego que ilustra el recorrido que se debe realizar con los niveles existentes, los cuales son acompañados de un número que identifica el nivel.

FIGURA1. Mapa del juego

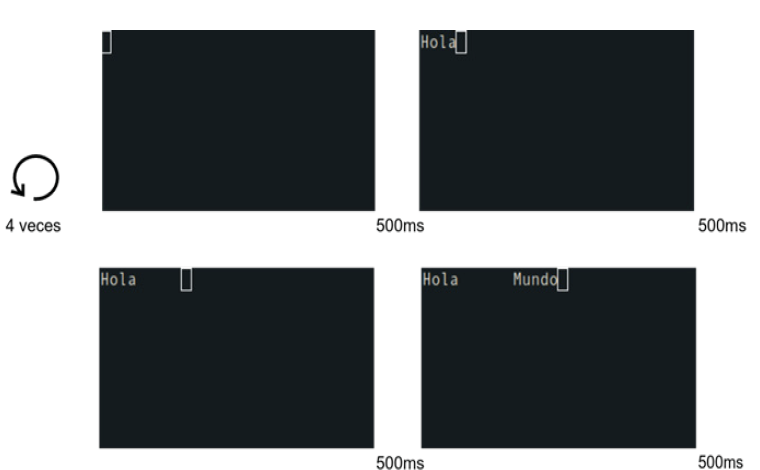

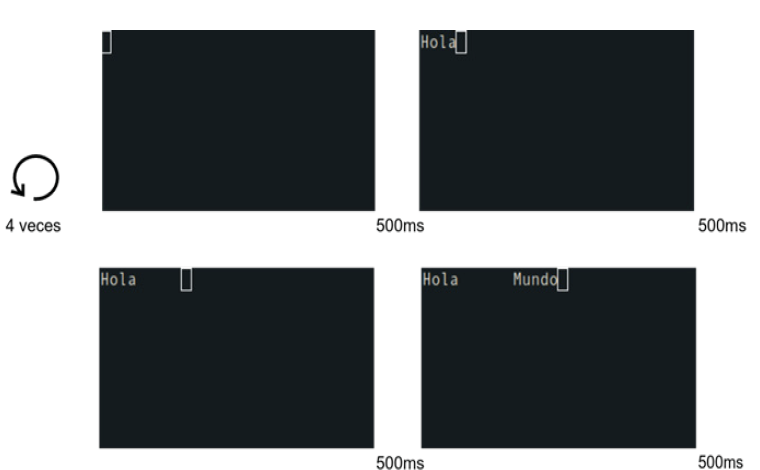

En la Figura 2 se muestra un ejemplo de un algoritmo en ejecución, el cual corresponde a la siguiente secuencia de instrucciones: primero, limpiar la pantalla; segundo, esperar 500 ms; tercero, mostrar el mensaje “Hola”; cuarto, esperar 500 ms; quinto, agregar 6 caracteres de espacio; sexto, esperar 500 ms; séptimo, mostrar el mensaje “Mundo”; octavo, esperar 500 ms; y noveno, repetir 3 veces los pasos anteriores.

FIGURA 2. Algoritmo en ejecución

En la Figura 3 se muestra la pantalla que aparece luego de la ejecución del algoritmo. En la parte superior se muestra el mensaje “Seleccione el algoritmo correcto” y un mensaje que identifica al algoritmo, en este caso “Opción 1”; en el centro de la pantalla se presenta un algoritmo, que en este caso coincide con el algoritmo que fue ejecutado (ver Figura 2); y en la parte inferior de la pantalla se distribuyen las opciones para: ejecutar de nuevo el algoritmo (A), seleccionar el algoritmo actual (S), o cambiar a otro algoritmo dentro de las cuatro alternativas (D). El código fuente del juego se puededescargar en github.com/jose6alejandro/JUSECA.

FIGURA 3. Algoritmo de la opción 1

3.2. Evaluación

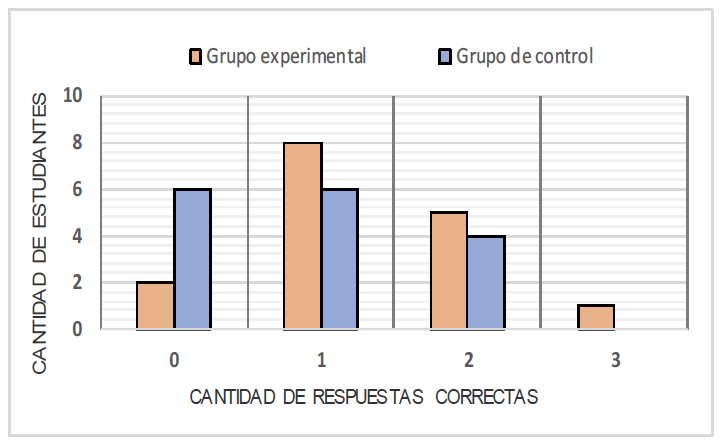

Los resultados obtenidos de la evaluación ad hoc de rendimiento que fue aplicada a los dos grupos al final del experimento, se pueden apreciar en la Figura 4, donde el color naranja representa al grupo experimental y el color azul al grupo de control; el eje horizontal es la cantidad de respuestas correctas y el eje vertical es la cantidad de estudiantes que respondieron correctamente.

FIGURA 4. Resultados de la evaluación ad hoc de rendimiento

Al comparar los dos grupos, se observan mejores resultados en el grupo experimental, donde sólo 2 estudiantes no respondieron correctamente alguna de las tres preguntas, a diferencia del grupo de control, donde fueron 6 estudiantes. Una pregunta fue respondida correctamente por 14 estudiantes, 8 del grupo experimental y 6 del grupo de control; dos preguntas fueron acertadas por 9 estudiantes, 5 y 4 por cada grupo respectivamente; y las tres preguntas, fueron respondidas correctamente por 1 estudiante perteneciente al grupo experimental.

Los resultados de MEEGA+, que fueron obtenidos a través del cuestionario aplicado a los 16 estudiantes del grupo experimental, fueron positivos. Por un lado, permitieron identificar las opiniones de los estudiantes sobre las dimensiones relacionadas a la usabilidad y experiencia de usuario, y, por otro lado, establecer el nivel de calidad en el que se ubica JUSECA. Para el análisis de los resultados, las opiniones “de acuerdo” y “totalmente de acuerdo” son consideradas como favorables. Así mismo, las opiniones “en desacuerdo” y “totalmente en desacuerdo” son consideradas como desfavorables. A continuación, se resaltan los resultados más importantes. No obstante, una tabla detallada por ítem se puede encontrar en github.com/jose6alejandro/JUSECA.

En términos generales, la usabilidad del juego cumplió con las expectativas de diseño, destacándose algunos aspectos de sus dimensiones: la estética fue considerada adecuada por el 81% de los estudiantes, quienes indicaron que los textos, colores, y fuentes combinan y son consistentes; la facilidad de aprendizaje y operatividad fueron favorables para el 87%, quienes creen que la mayoría de las personas pueden aprender a jugar JUSECA rápidamente, y que las reglas del juego son claras y comprensibles; por su parte, la accesibilidad es considerada oportuna por el 94% de los estudiantes, quienes emitieron opiniones favorables sobre el tamaño y estilo de las fuentes utilizadas en el juego.

La experiencia de usuario también obtuvo una tendencia favorable de manera general. Algunos aspectos que se pueden resaltar son: primero, el juego proporcionó, a la mayoría de los estudiantes, confianza y satisfacción (87% indicó que la estructura del juego les daba la confianza suficiente para reconocer que podían aprender algo, y 81% señaló que completar las tareas del juego les permitió obtener una sensación de logro); segundo, el juego representa un desafío para los estudiantes (75% afirmó que el juego presenta nuevos retos a un ritmo adecuado); y tercero, el juego también representa diversión (77% indicó que se divirtieron durante el juego).

Por otro lado, en la experiencia de usuario se encontraron algunas debilidades. Por ejemplo, en la dimensión de atención centrada, aunque el 63% de los estudiantes captaron que la experiencia era buena y se sentían inmersos en la atmosfera del juego, el 37% no estaba seguro de eso o tenían una opinión desfavorable. Por su parte, en el sentido de pertinencia hacia el juego, aunque el 100% consideró que el juego es un método de aprendizaje apropiado para la asignatura, el 63% de los estudiantes no estaban seguros si el juego es un método de aprendizaje más apropiado que los otros métodos utilizados en la asignatura.

Finalmente, para obtener el parámetro θ, se utilizó la herramienta proporcionada por MEEGA+ para determinar la calidad del juego. En este caso, JUSECA se ubicó en el rango de “buena calidad” con un valor de θ = 58.1, lo cual indica que, a pesar de tener una tendencia favorable de manera general en la opinión de los estudiantes, las debilidades encontradas impiden que el juego sea calificado dentro de la mejor categoría (excelente calidad).

4. DISCUSIÓN

Los resultados de la evaluación ad hoc de rendimiento muestran de manera general que los estudiantes del grupo experimental tuvieron mejor desempeño que los estudiantes del grupo de control. Estos resultados generales concuerdan con las investigaciones presentadas en la sección de juegos serios, donde se compara el impacto de los juegos serios con estrategias tradicionales, como se hace por ejemplo en (Garcia-Iruela, & Hijón-Neira, 2017). Es importante destacar que estos resultados pueden ser atribuidos al “efecto novedoso” (Koch et al., 2018), el cual tiende a estimular efectos positivos durante el periodo de novedad, tal como sucede en este caso, porque los estudiantes utilizaron el juego sólo una vez, y aunque la duración del “efecto novedoso” de este juego serio no es tomada en cuenta, se asume que durante el experimento se mantuvo el efecto debido a su diseño de corta duración.

El grupo experimental también obtuvo mejor desempeño en cada pregunta de la evaluación ad hoc de rendimiento: en el grupo de control, 6 estudiantes respondieron incorrectamente todas las preguntas, lo cual representa un 37.5% de los estudiantes del grupo de control; a diferencia, en el grupo experimental, sólo 2 estudiantes respondieron incorrectamente todas las preguntas, representando un 12.5%. Lo anterior indica que el juego serio capta la atención e involucra a más estudiantes que la estrategia tradicional, con respecto a la resolución correcta de al menos una pregunta, tal como se expresa en Garcia-Iruela e Hijón-Neira (2017). Las preguntas 1, 2 y 3 fueron respondidas correctamente por una cantidad similar de estudiantes en ambos grupos, lo cual sugiere que no hay diferencia significativa en el impacto del juego serio, tal como sucede en Yeh y Chen (2011), cuya posible explicación puede ser el pequeño tamaño de la muestra.

En los resultados de MEEGA+, JUSECA fue calificado como de “buena calidad”, lo cual indica que el juego contiene principalmente elementos positivos. Los elementos más favorables del juego propuesto están asociados a la experiencia de usuario, la pertinencia, la percepción del aprendizaje, la facilidad de aprendizaje, la operatividad, y la accesibilidad. Por otra parte, algunos de los elementos desfavorables fueron: la interacción social, la estética y los desafíos a lo largo del juego. Cabe destacar que, aunque los porcentajes de interacción social son desfavorables, el motivo probablemente está relacionado con el diseño de la actividad que estuvo destinada para la casa. Por su parte, las debilidades de estética quizás se deben al uso de la terminal de Linux como interfaz gráfica porque es limitada para proporcionar una apariencia agradable, y, además, imposibilitando la inclusión de elementos con formas redondas que propicien emociones positivas para el aprendizaje (Plass et al., 2014).

Finalmente, las debilidades relacionadas a los desafíos a lo largo del juego, quizás se deben a que sólo se crearon tres niveles de dificultad que no ofrecieron retos más complejos que los explicados en las clases presenciales, lo cual está relacionado con la dificultad óptima de cada estudiante. Al respecto, Charsky (2010) menciona que el jugador debe poder seleccionar el nivel de dificultad para propiciar la motivación con problemas óptimos. Por su parte, Van Lankveld et al. (2010) indican que cuando la dificultad aumenta de manera progresiva se debe tener en cuenta que si la dificultad no es óptima los jugadores se pueden aburrir o frustrar.

5. CONCLUSIONES

El juego serio JUSECA, presentado en esta investigación, cubre la necesidad de estimular la comprensión de los algoritmos utilizados para la enseñanza de la programación de computadoras en la asignatura “Programación 1”, los cuales son codificados en lenguaje C, utilizando la biblioteca PR1-ULA, para facilitar el primer acercamiento a la programación. La estrategia del juego para motivar a los estudiantes se basó en una historia que requiere que el jugador avance por tres lugares imaginarios del mundo donde se van presentando ejecuciones de algoritmos. Por otra parte, la estrategia para motivar la comprensión de algoritmos consiste en permitir que el jugador seleccione el algoritmo correcto entre varias opciones presentadas.

En la evaluación ad hocde rendimiento, tal como era de esperarse, los estudiantes del grupo experimental tuvieron mejor desempeño que los estudiantes del grupo de control. Sin embargo, la diferencia de los estudiantes que respondieron correctamente las preguntas de esta evaluación no fue significativa. No obstante, la diferencia de estudiantes que responden incorrectamente todas las preguntas es mayor, lo cual indica que el impacto del juego serio está orientado hacia la captación de más estudiantes para al menos responder de manera correcta una pregunta, posiblemente por el “efecto novedoso”, pero realmente no representa una mejora sustancial, lo cual sugiere la necesidad de un marco de trabajo orientado a juegos serios que garantice un fuerte impacto en los estudiantes. Es importante mencionar que los autores de esta investigación desconocen la existencia de un marco de trabajo con esa característica.

La evaluación con MEEGA+ clasificó el juego serio JUSECA como de “buena calidad”, lo cual hace referencia, en términos generales, a una buena experiencia de usuario y usabilidad de un juego educacional. Los trabajos futuros estarán orientados a incrementar el impacto del juego en el rendimiento de los estudiantes, y para ello, entre otras cosas, se deben incluir otros niveles con mayor dificultad permitiendo la adaptación del nivel según el estudiante, y además mejorar la estética, por ejemplo, integrando formas redondas que se combinen correctamente con colores cálidos, en aras de fomentar emociones positivas.

Otros trabajos futuros están relacionados con el prometedor impacto del pensamiento computacional, no sólo en al ámbito profesional, sino también en la vida cotidiana (Pérez, 2019b). Particularmente, en este trabajo se ha utilizado el juego serio propuesto para facilitar la comprensión de algoritmos en estudiantes de una carrera que requiere conocimientos de programación, como es el caso de la Ingeniería de Sistemas, quedando como trabajo futuro medir su impacto en estudiantes universitarios de otras carreras, y aumentar el tamaño de la muestra para que permita obtener resultados con mayor fiabilidad.

6. REFERENCIAS

Alcid, A. S., Bandril, L. B. P., De Guzman, A. E., & Lopez, L. J. C. (2017). Analysis, Design, Development, Implementation, and Evaluation of a Serious Game Designed to Inform Users on Environmental Issues. International Journal of Computing Sciences Research, 1(1), 11-23. https://doi.org/10.25147/ijcsr.2017.001.1.01

Butler, Y. G. (2014). The use of computer games as foreign language learning tasks for digital natives. System, 54, 91-102. https://doi.org/10.1016/j.system.2014.10.010

Calderón, A., Petri, G., Ruiz, M., & von Wangenheim, C. G. (2019). Juegos serios para formar en los conceptos del lenguaje C: una experiencia en Fundamentos de Informática. Actas de las JENUI, 4, 199-206.

Cano, S., Arteaga, J.M., Collazos, C.A., González, C.S., & Zapata, S. (2016). Toward a methodology for serious games design for children with auditory impairments. IEEE Latin America Transactions, 14(5), 2511- 2521. https://doi.org/10.1109/TLA.2016.7530453

Carrillo, L, M., Gómez V, E., & Orozco M, J. (2017). Estrategia para la enseñanza de algoritmos y programación en ingeniería mediante el uso de la lúdica como herramientas TIC. Encuentro Internacional de Educación en Ingeniería. https://acofipapers.org/index.php/eiei/article/view/569

Castro, C., Muñoz, J., & Brazo, A. (2018). El uso de videojuegos serios en el aprendizaje de francés en educación superior. Revista Mexicana de investigación educativa, 23(76), 157-177.

Cuesta, L. (2010). The Design and Development of Online Course Materials: Some features and Recommendations. Porfile Issues in Teachers Preofessional Development, 12(1), 181-201.

Charsky, D. (2010). From edutainment to serious games: A change in the use of game characteristics. Games and culture, 5(2), 177-198. https://doi.org/10.1177/1555412009354727

Fava, L. A., Schiavoni, M. A., Rosso, J., Falcone, A. C., & Ronconi, L. (2016, 3-7 de cotubre). ALGOLIPSE: una herramienta educativa para mejorar la comprensión de algoritmos y estructuras de datos [Comunicación congreso]. XXII Congreso Argentino de Ciencias de la Computación (CACIC 2016)(pp. 1280-1290), San Luis, Argentina. http://sedici.unlp.edu.ar/handle/10915/55718

Garcia-Iruela, M., & Hijón-Neira, R. (2017, 7-9 de junio). Experiencia de juegos serios en el aula de formación profesional [Comunicación congreso]. V Congreso Internacional de Videojuegos y Educación. (CIVE, 2017), Lleida, España. http://riull.ull.es/xmlui/handle/915/6682

Gugerty, L., & Olson, G. (1986). Debugging by skilled and novice programmers. ACM SIGCHI Bulletin, 17(4), 171-174. https://doi.org/10.1145/22627.22367

Hernández Sampieri, R., Fernández Collado, C., & Baptista Lucio, P. (2010). Metodología de la investigación. MCGRAW-HILL.

Kazimoglu, C., Kiernan, M., Bacon, L., & MacKinnon, L. (2012). Learning programming at the computational thinking level via digital game-play. Procedia Computer Science, 9, 522-531. https://doi.org/10.1016/j.procs.2012.04.056

Koch, M., Von Luck, K., Schwarzer, J., & Draheim, S. (2018). The Novelty Effect in Large Display Deployments-Experiences and Lessons-Learned for Evaluating Prototypes. European Society for Socially Embedded Technologies (EUSSET), 2(1), 2510-2591. https://doi.org/10.18420/ecscw2018_3

Maldonado, F., García, M., & Bencomo, O. (2017). Los juegos serios y su influencia en el uso responsable de energía y cuidado del medio ambiente. Revista Universidad y Sociedad, 9(1), 129-136.

Miljanovic, M., & Bradbury, J. (2016). Robot ON!: A Serious Game for Improving Programming Comprehension. IEEE/ACM 5th International Workshop on Games and Software Engineering (GAS). https://doi.org/10.1145/2896958.2896962

Molenda, M. (2003). In search of the elusive ADDIE model. Performance Improvement, 42(5), 34-36. https://doi.org/10.1002/pfi.4930420508

Petri, G., Von Wangenheim, C. G., & Borgatto, A. F. (2018). MEEGA+, Systematic Model to Evaluate Educational Games. En N. Lee (Ed.), Encyclopedia of Computer Graphics and Games. https://doi.org/10.1007/978-3-319-08234-9_214-1

Pérez, J. (2019a). DINADI: una estrategia para el diagnóstico de nativos digitales en el ámbito universitario. Revista Paradigma, 40(1), 56-75.

Pérez, J. (2019b). El pensamiento computacional en la vida cotidiana. Revista Scientific, 4(13), 293-306. https://doi.org/10.29394/Scientific.issn.2542-2987.2019.4.13.15.293-306

Pérez, J., & Azuaje, M. (2019). LE1: una estrategia amistosa para un curso introductorio de programación. Revista Educación En Ingeniería, 14(28), 45-53. https://doi.org/10.26507/rei.v14n28.998

Pérez J., & Castro J. (2018a). Estímulo del razonamiento lógico mediante el juego Millonario en C para la asignatura “Programación 1”, Revista Tekhné, 21(3), 8-14.

Pérez J., & Castro J. (2018b). LRS1: Un robot social de bajo costo para la asignatura “Programación 1”, Revista Colombiana de Tecnologías de Avanzada, 2(32), 68-77.

Pérez J., & Pedroza O. (2018). LM1: una metodología de estudio para la asignatura “Programación 1”, Revista Educere, 22(73), 635-648.

Poy-Castro, R., Mendaña-Cuervo, C., & González, B. (2015). Diseño y evaluación de un juego serio para la formación de estudiantes universitarios en habilidades de trabajo en equipo. RISTI-Revista Ibérica de Sistemas e Tecnologias de Informação (spe3), 71-83. https://doi.org/10.17013/risti.e3.71-83

Plass, J. L., Heidig, S., Hayward, E. O., Homer, B. D., & Um, E. (2014). Emotional design in multi-media learning: Effects of shape and color on affect and learning. Learning and Instruction, 29, 128-140. https://doi.org/10.1016/j.learninstruc.2013.02.006

Ramalingam, V., & Wiedenbeck, S. (1997). An empirical study of novice program comprehension in the imperative and object-oriented styles. In Papers presented at the seventh workshop on Empirical studies of programmers, (pp. 124-139).ACM. https://doi.org/10.1145/266399.266411

Renavitasari, I. R. D., & Supianto, A. A. (2018). Educational Game for Training Spatial Ability Using Tangram Puzzle. In 2018 International Conference on Sustainable Information Engineering and Technology(pp. 174-179). SIET. https://doi.org/10.1109/SIET.2018.8693164

Rodero, C. L., Velasco, M. P., Iturbide, J. A. V., & Losada, I. H. (2017). Experiencia para la evaluación de VisBack, una herramienta para la visualización de algoritmos de backtracking. IE Comunicaciones: Revista Iberoamericana de Informática Educativa, (26), 82-93.

Rosanigo, Z. B., & Paur, A. B. (2006). Estrategias para la enseñanza de Algorítmica y Programación [Comunicación en congreso]. I Congreso de Tecnología en Educación y Educación en Tecnología.

Taipe, M. S. A., Pesántez, D. Á., Rivera, L., & Vizueta, D. O. (2017). Juegos Serios en el Proceso de Aprendizaje. UTCIENCIA, 4(2), 111-122.

Van Lankveld, G., Spronck, P., Van Den Herik, H. J., & Rauterberg, M. (2010). Incongruity-based adaptive game balancing. En H.J. van den Herik, & P. Spronck (Eds.), Advances in Computer Games. ACG 2009. Lecture Notes in Computer Science, 6048(pp. 208-220). Springer. https://doi.org/10.1007/978-3-642-12993-3_19

Velázquez-Iturbide, J. Á., & Pérez-Carrasco, A. (2016). Systematic development of dynamic programming algorithms assisted by interactive visualization. En Proceedings of the 2016 ACM Conference on Innovation and Technology in Computer Science Education(pp.71-76). ACM. https://doi.org/10.1145/2899415.2899450

Von Wangenheim, C. G., Araújo E Silva De Medeiros, G, Missfeldt Filho, R., Petri, G., Da Cruz Pinheiro, F., Ferreira, M. N. F., & Hauck, J. C. (2019). SplashCode-A Board Game for Learning an Understanding of Algorithms in Middle School. Informatics in Education, 18(2), 259–280. https://doi.org/10.15388/infedu.2019.12

Williams, P., Schrum, L., Sangrá, A., & Guárdia, L. (2003). Fundamentos del diseño técnico pedagógico en e-learning. Modelos de diseño instruccional.

Yeh, K., & Chen, W. (2011). WIP: Using a computer gaming strategy to facilitate undergraduates’ learning in a computer-programming course: an experimental study. En Proceedings of the 41st ASEE/IEEE Frontiers in Education Conference(pp.11-12). ASEE/IEEE. https://doi.org/10.1109/FIE.2011.6142944